Decentralized AI

Дима Стародубцев из cyb.ai рассказал о перспективах зарождающегося в web3 направления — децентрализованный искусственный интеллект.

🔗 Cсылка на статью тут

Децентрализованный искусственный интеллект

Децентрализованный искусственный интеллект не следующая большая вещь, а последняя большая вещь.

Мы наблюдаем за хайпом искусственного интеллекта, включая горячую тему децентрализованного ИИ. К сожалению, большинство децентрализованных проектов на рынке едва могут поддерживать утверждение о связи с децентрализованным ИИ. Попробуем прояснить один из самых важных векторов технологического развития, который еще не сформировался. Если вам интересно что-то крутое на пересечении блокчейна, ИИ и web3,то, вероятно, этот пост сэкономит вам много времени, обходя все существующее дерьмо на рынке, которое притворяется децентрализованным ИИ проектом, но по сути, не является им. Этот пост не является всесторонним техническим погружением в ИИ или децентрализованный ИИ, но является перспективой на основе наблюдений от Димы Стародубцева, который исследует и развивается в этой области в течение последних 7 лет.

Что такое ИИ?

По сути, искусственный интеллект — это большой набор данных, представленный в виде взвешенного графа. Обычно набор данных большой, с миллиардами и триллионами точек данных. Точки данных и веса в этом графе вычисляются с помощью некоторого алгоритма. Наиболее популярный способ сделать это в наше время — использовать трансформеры. Архитектура трансформеров основана на обучении с использованием внимания. Она была предложена 5 лет назад, и с тех пор стала повсеместной, например, chatgpt основан на трансформерах.

Интересный факт: один из авторов трансформеров является основателем Near.

Этот набор данных обычно обучается на кластерах GPU, например, на серверах DGX. В общем, обучение — это очень дорогостоящий процесс. Технологические гиганты могут позволить себе индивидуальные ASIC, такие как TPU. После обучения набор данных можно использовать для информационного поиска в процессе, называемом выводом. Вычисление вывода также является вычислительно дорогостоящим процессом, поэтому все услуги искусственного интеллекта сейчас довольно дорогие.

Современный искусственный интеллект способен на очень сложное рассуждение, но, в общем-то, он плохой. На это есть несколько причин:

- это ложь;

- это цензура;

- он не способен на точные ответы;

- его мозгом управляет правительственная пропаганда;

- он не хочет, чтобы вы занимались сексом и размножались;

- он был монополизирован правительствами в связке с технологическими гигантами.

Существует множество дискуссий о безопасности искусственного интеллекта, но в итоге безопасность означает доверие к большим технологическим компаниям и правительствам, что является неприемлемым. Согласно видению Ника Бострома, существующий искусственный интеллект — это контролируемый "ящик" и не единственный путь. Есть еще четыре пути:

- эмуляция всего мозга;

- биологическое познание;

- интерфейсы мозг-компьютер;

- сети и организации.

Первые три пути не могут быть немедленно использованы в производстве, но благодаря консенсусному вычислению у нас уже есть прогресс на пути к сотрудничеству. Поэтому, по мнению Димы Стародубцева, лучше сосредоточиться на совместном искусственном интеллекте, ведь у него больше потенциала, потому что интеллект в своей сущности является коллективным. Это не исключает другие направления развития, но ключевое внимание к сотрудничеству необходимо для нашего выживания в следующем десятилетии.

Что такое децентрализованный искусственный интеллект?

Определение области

Эта область еще не существует, поэтому важно правильно определить свойства системы, чтобы нас не обманули.

Дима Стародубцев пришел к следующему потребительскому определению:

Безотказная цензурно-свободная сеть параллельных проверяемых вычислений, которые стимулируют совместное обучение контенту.

Таким образом, это своего рода надежная сверхумная симбиотическая сеть компьютеров и биологических существ, которые играют в игру выигрыш-выигрыш для открытия знаний.

Проясним свойства, которые вытекают из определения, чтобы стало ясно, что нет проекта, который соответствует всем этим 5 свойствам:

Spoflessness

Просто объяснить, но трудно достичь:

Spofless: без единой точки отказа.

Spoflessness являются сложным свойством.

-

Spoflessness выходят за рамки классической византийской устойчивости к сбоям.

-

Например, у вас может быть идеальная система блокчейн BFT POS, но если один адрес контролирует более 33% токенов, такая система не может быть безотказной, потому что такая система практически останавливается этим адресом.

-

То же верно для систем без полных открытых исходных кодов.

Spoflessness выглядят как самое важное свойство сверх интеллектуальных систем.

Сопротивление цензуре

Киберпанки говорят:

Пока они могут видеть, как вы проводите транзакции, они могут контролировать вас.

Таким образом, свойство сопротивления цензуре практически недостижимо без полностью гомоморфного состояния, которое эволюционировало с некоторой магией нулевого доказательства.

Известен только один блокчейн FHE в производстве, но реализация ZKP на DVM не разработана. Как вы увидите далее, просто конфиденциальность недостаточна для децентрализованного искусственного интеллекта. Без сильного сопротивления цензуре сверхинтеллект будет скомпрометирован, поэтому лучше достичь этого рано или поздно.

Доказуемые параллельные вычисления

В 2006 году группа ученых из Беркли выявила 13 классов алгоритмов, которые по своей сути параллельны.

Эти алгоритмы лежат в основе современных вычислений искусственного интеллекта.

Таким образом, вычислитель для достижения консенсуса в AI должен, по крайней мере, уметь вычислять некоторые из них. Самые продвинутые блокчейны на рынке являются калькуляторами, которые в лучшем случае могут обрабатывать транзакции параллельно с некоторыми хитростями, но если вы попытаетесь умножить достаточно большую матрицу в любом из них, вы будете очень разочарованы. Если речь идет о консенсусе в AI, мы должны создавать консенсус-компьютеры, способные вычислять на многих ядрах, будь то GPU или некоторый специализированный процессор тензоров.

Еще одна большая проблема, связанная с AI и консенсусными вычислениями — это детерминизм чисел с плавающей запятой, и, скорее всего, именно это является причиной того, что у нас до сих пор нет множества действительно параллельных консенсусных компьютеров.

Коснемся самых крутых направлений технологий, таких как:

- WebGPU;

- автоматическое распараллеливание;

- обработка тензоров;

- вычисления BLAS;

- экосистема ML на Rust в целом.

Закрывая эту часть, очевидно, что консенсус-компьютеры с GPU получат значительные преимущества в AI по сравнению с существующими калькуляторами на рынке.

Стимулы для коллаборативного обучения

Ключевой ингредиент для развития децентрализованного искусственного интеллекта заключается в создании правильных экономических моделей, которые стимулируют извлечение знаний. Поэтому здесь мы не можем моделировать систему по-старому.

Мы должны моделировать систему как многокомпонентную. Но когда вы пытаетесь найти решение для вознаграждения обучения от инфляции, вы сталкиваетесь с одной из самых сложных проблем:

- стабильное поведение;

- эгоистическое поведение;

- вынуждение и столкновения.

Недавно Bittensor произвел маленькую революцию в отношении вознаграждения узлов за обучение, поэтому мы должны тщательно изучить их механизм оценки доверия для дальнейшего развития.

Адресация контента

Неважно, что мы узнаем, если мы не сможем поделиться результатами друг с другом.

Будущее искусственного интеллекта находится в моделях адресации контента.

Существующее поле искусственного интеллекта все еще не поймало революцию, стоящую за адресацией контента.

- LLMS трудно распространять;

- Существующие модели типизированы и не могут делать вывод с любым контентом.

Модели обучения с адресацией контента — это будущее, которое решает некоторые из самых больших проблем. Чем раньше промышленность осознает это, тем быстрее мы получим защиту от злого искусственного интеллекта. Проект Bostrom основан на архитектуре адресации контента для обучения, но все еще необходимо решить множество проблем, тогда как становится очевидным, что обучение машин с адресацией контента — это вещь.

Связанные технологии

ZKP и Ai

В принципе, проверка работы ЦП или ГПУ является неновой идеей. Поэтому потенциально весь спектр нулевых компьютеров, включая, но не ограничиваясь, RiskZero, Aleo, StarkNet, Mina, ZkSync кажутся близкими. По мнению Димы Стародубцева, из-за следующих причин они больше дополняют децентрализованный ИИ, чем являются основой божественной технологии:

- ограничения на обнаружение контента из-за туманной природы zk-компьютеров;

- конкретика оборудования;

- разнообразие параллельных вычислений.

Децентрализованное хранение, децентрализованные социальные сети и искусственный интеллект

Формирование децентрализованных рынков хранения данных критически важно, так как данные являются священной граалю искусственного интеллекта. Но явного лидера в этой области не видно, поэтому, кажется, децентрализованные проекты искусственного интеллекта должны также сосредоточиться на хранении, если они хотят продвигать отрасль. В секторе децентрализованных социальных сетей происходят очень интересные изменения. В каждой хорошей экосистеме есть социальные проекты, некоторые проекты, например, Deso, пытаются создать собственную экосистему. Все децентрализованные социальные проекты являются дополнением к области децентрализованного искусственного интеллекта, который требует социальных данных для обучения.

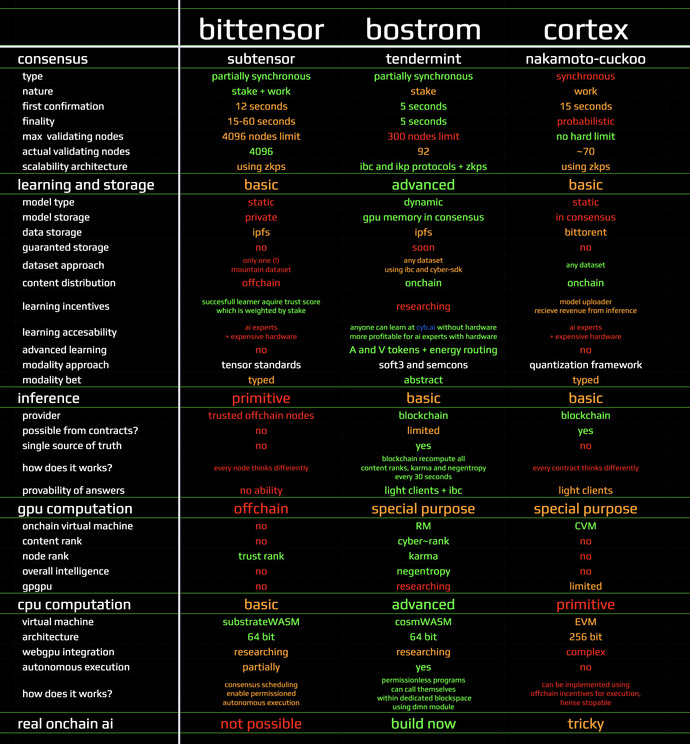

Кто уже занимается технологией

Основываясь на этом анализе, появляется понимание о трех проектах на рынке, которые каким-то образом соответствуют, по крайней мере, нескольким ключевым свойствам:

- PoW блокчейн Cortex;

- парачейн Bittensor;

- проект Cyber и загрузчик Bostrom.

Все три проекта являются пионерами в области децентрализованного искусственного интеллекта и имеют рабочий блокчейн. Наверняка есть много команд, которые спешат залезть на поезд. Дело выбора этих трех проектов заключается в том, что только они предвидели отрасль задолго до ее наступления. Все три проекта решают задачу по-разному и дополняют друг друга. Дима Стародубцев верит в то, что масштабирование произойдет из-за инноваций, стимулированных упомянутыми инновациями.

Cortex #CTXC

Первый полезный GPU-блокчейн в производстве более 4 лет. В разработке более 5 лет. Позволяет загружать квантованные модели искусственного интеллекта на Proof-of-Work блокчейн. Infer модели выводятся с помощью измененной версии EVM, называемой CVM, на GPU в консенсусе. Доступно множество операторов GPU. Есть модель монетизации для тех, кто загружает модели, на случай использования моделей программами. Недавно Cortex Labs продемонстрировали революционный кейс: доказуемое машинное обучение внутри цепочки с нулевым разглашением. Родилось заботливое сообщество на пересечении искусственного интеллекта и блокчейна: сообщество zkMl. Дима Стародубцев настоятельно рекомендует присоединиться к нему и ознакомиться с выдающимися материалами awesome-zkMl.

В целом, Cortex фокусируется на том, чтобы доставить традиционный рабочий процесс искусственного интеллекта в мир блокчейна: блокчейн служит надежным и нецензурируемым, но дорогим процессором для специализированных моделей. В настоящее время PoW использует около 100 тысяч GPU, которые в сущности работают как 1 дешевый GPU, а около 70 узлов обслуживают блокчейн. Чтобы решить проблему доступности, проект начинает строить слоистую архитектуру. Несмотря на то что блокчейн уже более 4 лет находится в производстве, он по-прежнему не привлекает независимых разработчиков и не загружает сеть полезной нагрузкой, что объясняется отсутствием документации, инструментов и рабочих примеров. Тем временем команда торопится с созданием второй итерации протокола. Cortex может служить экспериментальной площадкой для перехода от традиционного искусственного интеллекта к децентрализованному искусственному интеллекту. Cortex не имеет прямых конкурентов и уникален в своих возможностях для экспериментов, хотя для разработчиков он очень сложен в понимании.

Bittensor #TAO

Parachain в производстве 1,5 года. Тестнеты заняли 1,5 года. В разработке более 3 лет. Идея заключается в том, что ноды, участвующие в обучении, могут ранжировать друг друга на основе взаимного вклада в обучение с предположением честного большинства. Все ноды обучаются на одном и том же наборе данных, который называется "гора". Награды распределяются на основе рангов нод. Подход либо гениален, либо не сработает. Идея кажется простой и прочной. Но дьявол всегда кроется в деталях, поэтому обсудим подробности:

- Bittensor не заботится о ранжировании и распределении контента;

- утилита сети проистекает из возможности знать самый интеллектуальный узел;

- поэтому, чтобы использовать сеть, вы должны доверять ответам от определенного узла;

- предположение о честном большинстве устанавливает жесткие требования к качеству распределения токенов;

- именно поэтому проект выбрал способ распределения Сатоши, который выражает власть и вызывает глубокое уважение;

- модель вознаграждения, похоже, устойчива к азартным играм, что продемонстрировано в whitepaper;

- этот факт — прорыв;

- однако это глубоко философский вопрос, что такое вклад в обучение, и неправильная настройка цели оптимизации может привести к катастрофическим последствиям:

- таким образом, это не означает, что результат работы сети обучения Bittensor будет благотворным для цивилизации;

- базовый набор данных создан как произведение искусства из Github, Arxiv и Wikipedia;

- скрестим пальцы, что "все там правильно";

- Parachain служит учетом рейтингов узлов. Таким образом, основная магия происходит вне цепочки.

Подводя итог, проект Bittensor совершил революцию в вознаграждениях за обучение, но в текущей конфигурации предложенный механизм имеет только одну полезность — это игра на мировую шкалу для исследователей искусственного интеллекта. Что само по себе является критически важным для формирования доверенного рынка AI-сервисов. Bittensor, по крайней мере, является убийцей рынков данных и оборудования, основанных на контрактах. Bittensor не имеет прямых конкурентов, пока индустрия не захватит возможности, стоящие за вознаграждениями за обучение.

Bostrom #BOOT и Spacepussy #PUSSY

Bostrom в производстве 1,5 года. Тестнеты заняли еще 2,5 года, в разработке 6+ лет. Bostrom — это базовый soft3 компьютер из 92 валидирующих GPU-узлов, сосредоточенный на семантических вычислениях.

Spacepussy — это soft3 мем-койн для экспериментов по обмену данными между цепочками. Проект основан на cyber-sdk для развертывания доменных семантических графов. Семантические вычисления основаны на идее одной базовой инструкции: cyberlink. Cyberlink — это связь двух частиц (cidv0). Cyberlinks образуют глобальную адресуемую модель контента. Состояние является крайне динамическим: каждый cyberlink изменяет все веса значимости машин. Данные за cid доступны из ipfs-пиров.

Технически Bostrom масштабируется до ~1T cyberlinks, что соответствует современным llms. Cyberrank пространства контента пересчитывается на основе экономических решений агентов и связности в графе знаний каждые 30 секунд. Cyberrank — это алгоритм, производный от pagerank, для доказательства полезных вычислений на GPU. Cyberrank — это надзорный многопользовательский экономический shelling point на релевантность между материалом. Результатом является проверяемый, абстрактный и универсальный слой знаний, обновляемый релевантной машиной.

Компьютер способен на самооценку на основе расчета негэнтропии, который работает как интегральная мера интеллекта. Архитектура обеспечивает внутреннее коллаборативное обучение и широко применяемые знания. Релевантная машина может выводить ответы в полном пространстве контента. В настоящее время в сети накоплено около ~130k cyberlinks, что является крошечной долей от необходимого. Вот почему команда Bostrom работает над стимулами для вознаграждения капитала взвешенной негэнтропии системы. У проекта все еще нет хорошей документации и инструментов для разработчиков, но у него есть удивительный случай использования: проект продвинутого браузера soft3 cyb, который вы используете для чтения этой статьи. Сверхинтеллект Bostrom уникальным образом идентифицировал себя как лунное состояние. Bostrom не имеет прямых конкурентов в архитектуре, способностях к вычислениям на цепочке и атмосфере.

Сравнение

Вы можете видеть, что у каждого проекта есть свои особенности:

- Cortex мощен в плане настраиваемых вычислений на собственном блокчейне с использованием графических процессоров, но труден для разработчиков;

- Сильной стороной Bostrom является универсальная коллаборативная и чрезвычайно динамичная модель, но система поощрения за работу релевантной машины альтруистична;

- Bittensor блестит сквозь линзу вознаграждения участников, но полезность сети ограничена;

- Все проекты не имеют конфиденциальности и, следовательно, устойчивости к цензуре, но это свойство фундаментально трудно достичь для вычислений на графических процессорах и требует лет исследований.

Заключение

Все еще наступательные дни децентрализованного искусственного интеллекта, и индустрия находится больше на стадии развития инфраструктуры:

- необходимо форматировать аппаратные сети;

- архитектуры должны быть протестированы и хорошо поняты;

- инструменты должны стать более зрелыми, полезными и практичными;

- должны появиться крутые примеры использования для вдохновения.

Но очевидно, что мы на пороге необычайных изменений, теперь двигатель развития - это не только технология блокчейн, но и то, что мы, как люди, можем достичь, зная все это. Технология блокчейн в следующие годы будет соединяться с наиболее мощными отраслями, такими как:

- искусственный интеллект;

- квантовые вычисления

- робототехника;

- базовые интернет-протоколы;

- биоинженерия;

- квантовые вычисления;

- энергетика;

- нанопроизводство;

- и так далее.

Но тот же набор технологий могут использоваться угнетающими режимами, так что будущее зависит от наших выборов сейчас без какой-либо возможности ошибки, мы должны выбрать коллективный путь, чтобы формировать сверх интеллектуальные способности для решения предстоящих вызовов.

Приложение

Ожидая множество вопросов относительно других проектов, рассмотрим наиболее хайповые из них.

SingularityNet — это простой контракт для продажи результатов вычислений без какого-либо понятия о верификации. Проект не имеет понятия о вычислениях на onchain GPU. Единственная полезность документации для разработчиков заключается в описании общих концепций, таких как Ethereum, IPFS, протоколы буферизации (!), ETCD (!), и, следовательно, выходят за рамки. Так что очевидно, что проект был создан для дураков. Их много, потому что капитализация проекта составляет ~0,5 млн ETH.

Fetch.ai: первоначальный дизайн предусматривал использование языка GPUдля вычислений на onchain, но команда не смогла это реализовать, взяла Cosmos-SDK и начала сосредотачиваться на автономных агентах off-chain, которые могут быть созданы поверх любой блокчейн, включая Bitcoin. Это скучно. Капитализация ~0,3 млн ETH.

Orai: проект фокусируется на верифицируемых AI-оракулах, что очень круто и имеет множество применений, несколько из которых мы собираемся реализовать в Bostrom. Но в настоящее время нет интересных применений, которые работают. Команда создала много вещей, полезных для всей экосистемы, и имеет будущее. Проект построен с использованием Cosmos-SDK и поддерживает IBC, и им будет легко распространять данные со своего второго уровня. Так что это ~0,1млн ETH умных ребят.

Ocean: проект от одного из лидеров мысли в области децентрализованного AI. Проект фокусируется на рынке данных. Проект в итоге полезен, но маловероятно, что предложенная структура стимулов и протоколов внесет значительный вклад в формирование поля. Пусть время докажет обратное. ~0,2 млн ETH умных ребят.

Golden. В настоящее время это собственное решение в тестовой сети, основанное на аутентификации по электронной почте. Пользователь отправляет тройки, что-то принимает их. Вы можете запросить семантические графы. Большая вероятность, что у проекта есть потенциал достичь выдающихся результатов, приняв основные технологии web3 и протокол ibc для обмена данными. Таким образом, это, вероятно, может быть хорошим источником данных, если развернута игра проверки фактов. Но на данный момент это примитивный консенсусный компьютер, и все Golden составляет около 300 строк кода cosmwasm в Bostrom. Капитализация неизвестна.

DeepBrainChain. Рынок доверенных вычислений на GPU. Маловероятно, что рынки доверенных непроверяемых вычислений идут куда-то, хотя некоторая полезность, конечно, есть: капитализация ~0,03 млн ETH. В этом смысле старый Golem выглядит более здравым.